Pixel Reasoner项目简介

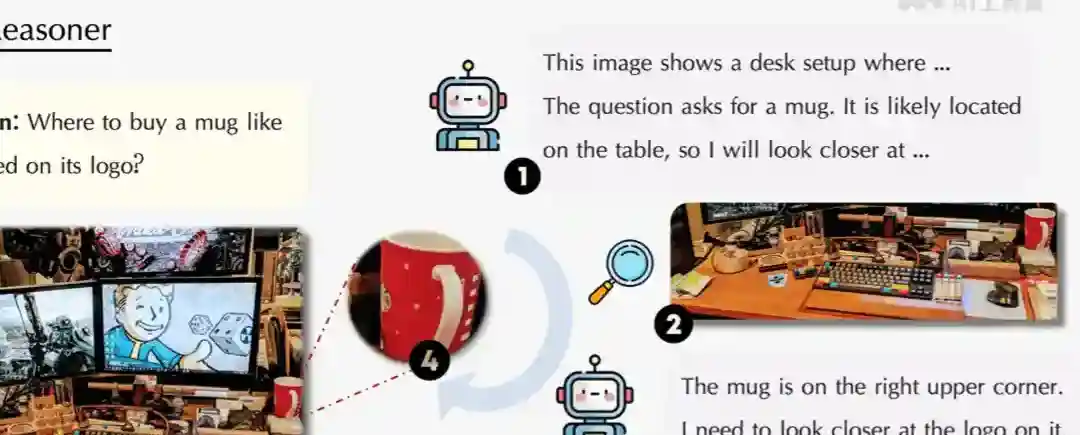

Pixel Reasoner是滑铁卢大学、香港科技大学、中国科学技术大学等机构推出的视觉语言模型(VLM),基于像素空间推理增强模型对视觉信息的理解和推理能力。模型能直接在视觉输入上进行操作,如放大图像区域或选择视频帧,更细致地捕捉视觉细节。Pixel Reasoner用两阶段训练方法,基于指令调优让模型熟悉视觉操作,用好奇心驱动的强化学习激励模型探索像素空间推理。Pixel Reasoner在多个视觉推理基准测试中取得优异的成绩,显著提升视觉密集型任务的性能。

Pixel Reasoner优势介绍

直接视觉操作:直接对视觉输入(如图像和视频)进行操作,例如放大图像区域(zoom-in)、选择视频帧(select-frame)等,更细致地捕捉视觉细节。

增强视觉理解:识别和理解图像中的细小物体、微妙的空间关系、嵌入的小文本及视频中的细微动作。

多模态推理:更全面地处理复杂的视觉语言任务,如视觉问答(VQA)、视频理解等。

自适应推理:根据任务需求自适应地决定是否使用视觉操作,在不同类型的视觉任务中实现更优的推理效果。

Pixel Reasoner详细报告

指令调优(Instruction Tuning):

收集种子数据:选择具有丰富视觉信息的图像和视频数据集,如SA1B、FineWeb和STARQA。

定位参考视觉线索:基于数据集的标注或使用GPT-4o生成的标注,确定与问题相关的视觉线索(如边界框或帧索引)。

合成专家轨迹:用模板化方法合成推理轨迹,确保模型在推理过程中正确使用视觉操作。例如,先对整个视觉输入进行分析,再触发特定的视觉操作提取细粒度的视觉细节,最后结合细节得出最终答案。

训练:用监督学习(Supervised Fine-Tuning, SFT)对模型进行训练,让模型熟悉视觉操作。基于插入错误的视觉操作并合成自我修正轨迹,增强模型对意外视觉结果的反应能力。

好奇心驱动的强化学习:设计一个包含好奇心奖励和效率惩罚的奖励函数,激励模型探索像素空间推理。

训练过程:用强化学习(RL)对模型进行训练,基于好奇心奖励激励模型探索像素空间推理,用效率惩罚限制视觉操作的数量。基于近策略RL方法,每512个查询更新一次行为策略和改进策略。在训练过程中,模型逐渐学会在适当的查询中用像素空间推理,在视觉操作失败时进行自我修正。

Pixel Reasoner的项目地址

项目官网:https://tiger-ai-lab.github.io/Pixel-Reasoner/

GitHub仓库:https://github.com/TIGER-AI-Lab/Pixel-Reasoner

HuggingFace模型库:https://huggingface.co/collections/TIGER-Lab/pixel-reasoner

arXiv技术论文:https://arxiv.org/pdf/2505.15966

在线体验Demo:https://huggingface.co/spaces/TIGER-Lab/Pixel-Reasoner

Pixel Reasoner主要应用

研究人员和开发者:研究人员和开发者进行模型训练和优化,特别是在视觉问答、视频分析等任务中,提升模型的性能和准确性。

教育工作者:教育工作者用在辅助教学,用直观的视觉展示和解释,帮助学生更好地理解和掌握复杂的概念。

工业质检人员:质检人员进行自动化视觉检查,快速识别产品外观缺陷,提高质量控制的效率和准确性。

内容创作者:创作者进行更精准的视觉内容分析和编辑,提升内容的质量和吸引力。