-

Recraft V3 – Recraft推出的AI文本到图像生成模型

Recraft V3项目简介 Recraft V3是Recraft公司推出的AI文本到图像生成模型,在Hugging Face的文本到图像模型排行榜上以1172的ELO评分荣获第一。模型具有高质量的图像生成和先进的设计控制功能,支持用户精确定位文本和元素,定制品牌风格和颜色。Recraft V3支持长文本生成,提供用户友好的界面和灵活的定价策略,能通过网站、移动应用或API使用,为设计师和创意专业…- 0

- 0

-

Insert Anything – 浙大联合哈佛大学和南洋理工推出的图像插入框架

Insert Anything项目简介 Insert Anything是浙江大学、哈佛大学和南洋理工大学的研究人员联合推出的基于上下文编辑的图像插入框架。框架基于将参考图像中的对象无缝插入到目标场景中,支持多种实际应用场景,如艺术创作、真实人脸替换、电影场景合成、虚拟试穿、配饰定制和数字道具替换等。Insert Anything基于包含120K提示图像对的AnyInsertion数据集训练,能灵活…- 1

- 0

-

美图奇想大模型 – 美图公司推出的AI视觉大模型

美图奇想大模型项目简介 美图奇想大模型(MiracleVision)是美图公司推出的一款AI视觉大模型,专注于美学创作,包括东方美学、人像和商业设计等。模型完成了视频生成能力的全面升级,能生成1分钟、每秒24帧、1080P分辨率的高质量视频,显著提升视频的画质、流畅性和真实性。升级后的模型在美图旗下的产品如美图秀秀、美颜相机、Wink等应用中使用,将逐步推广到其他产品,如开拍、美图设计室、WHEE…- 0

- 0

-

因赛AIGC – 因赛集团推出的AI营销工具

因赛AIGC项目简介 因赛AIGC是因赛集团推出的AI营销工具,InsightGPT结合AI技术与营销策略洞察、内容创意生产、传播投放及效果转化,提升营销行业的生产力。InsightGPT不仅具备图片创作、文案生成等基础功能,还通过智能化处理降低创作门槛,提高内容品质,生成更贴合用户需求的营销内容。InsightGPT的推出,展示了因赛集团在AIGC领域的专业领先优势,为营销行业带来创新解决方案。…- 2

- 0

-

豆包AI视频模型 – 字节跳动推出的AI视频生成大模型:PixelDance和Seaweed

豆包AI视频模型项目简介 豆包AI视频模型是字节跳动推出的两款AI视频生成大模型:PixelDance 和 Seaweed 。PixelDance基于DiT结构,擅长理解复杂指令,生成连贯、多主体交互的视频片段,适合制作故事性强的短片。Seaweed则基于Transformer结构,通过时空压缩技术训练,支持多分辨率输出,生成逼真、流畅的视频,适合多种商业应用场景。PixelDance适合需要复杂…- 2

- 0

-

BodyTalk – AI视频配音工具,自动适配新语音的唇形、面部表情和肢体动作

BodyTalk项目简介 BodyTalk是Panjaya推出的AI视频配音工具,基于生成性AI技术,将视频中的人物声音转换为其他语言,自动调整视频中人物的面部表情和肢体动作,自然地匹配新的语音模式。工具结合音频翻译、声音模仿和视频编辑技术,支持29种语言的翻译,提供自动化处理和编辑功能。BodyTalk主要面向B2B市场,与JFrog和TED等组织合作,提升视频内容的观看率和完成率。 BodyT…- 2

- 0

-

CHANGER – AI换头技术,将演员头部无缝集成到目标身体

CHANGER项目简介 CHANGER是工业级超自然AI换头与色键技术,用在数字内容创作中将演员头部无缝集成到目标身体上,适于视觉特效、数字人类创建和虚拟化身。CHANGER基于色键技术分离背景与前景,用H2增强模拟多样头部形状和发型,及FPAT模块预测、聚焦关键区域,实现高保真融合。CHANGER在性能上超越现有技术,适用于多种真实场景。 CHANGER优势介绍 高保真头部融合:将演员的头部无缝…- 1

- 0

-

DreamOmni – 港中文、字节等机构共同推出的统一图像生成和编辑模型

DreamOmni项目简介 DreamOmni 是香港中文大学、字节跳动和香港科技大学共同推出的统一图像生成和编辑模型。模型整合文本到图像(T2I)生成和多种编辑任务,包括指令式编辑、修复、拖拽编辑和参考图像生成。DreamOmni 基于一个高效的合成数据管道解决高质量编辑数据的创建难题,支持模型训练和扩展。基于联合训练T2I和编辑任务,强化对概念的理解并提升图像生成质量。在广泛的实验评估中,Dr…- 2

- 0

-

Click2Mask – AI图像编辑技术,通过简单点击和内容描述实现智能编辑

Click2Mask项目简介 Click2Mask 是一种先进的图像编辑技术,支持用户通过在图片上简单点击来实现局部编辑,无需复杂的遮罩或详细描述。通过动态生成遮罩,结合混合潜在扩散(BLD)过程和基于 CLIP 的语义损失来引导遮罩的生成,简化用户输入。Click2Mask 自动适应编辑需求,调整遮罩大小和形状,在指定区域内添加新内容,同时保持图片其他部分不变。适用于数字艺术创作、照片编辑和在线…- 1

- 0

-

AutoVFX – 自然语言驱动的视频特效编辑框架

AutoVFX项目简介 AutoVFX是先进的物理特效框架,是伊利诺伊大学香槟分校研究团队推出的,能根据自然语言指令自动创建真实感和动态的视觉特效(VFX)视频。框架集成神经场景建模、基于大型语言模型(LLM)的代码生成和物理模拟技术,实现照片级逼真且物理上合理的视频编辑效果,让用户能直接用自然语言指令控制视频内容的修改和创作。 AutoVFX优势介绍 3D场景建模:从输入视频中提取关键场景属性,…- 1

- 0

-

SigStyle – 吉大联合 Adobe 等机构推出的风格迁移框架

SigStyle项目简介 SigStyle 是吉林大学、南京大学智能科学与技术学院及Adobe推出的新型签名风格迁移框架,支持将单张风格图像中独特的视觉特征(如几何结构、色彩搭配、笔触等)无缝迁移到内容图像上。SigStyle基于个性化文本到图像扩散模型,用超网络高效微调模型捕捉签名风格,将风格表示为特殊标记。在迁移过程中,SigStyle 引入时间感知注意力交换技术,确保内容一致性。SigSty…- 1

- 0

-

SDXL-EcomID – 阿里推出的单个参考图像生成定制的个性图像框架

SDXL-EcomID项目简介 SDXL-EcomID是阿里妈妈推出的开源项目,从单个参考图像生成定制的个性图像。融合PuLID和InstantID的优点,优化背景一致性、面部关键点控制和面部真实性,提高生成图像的相似度。SDXL-EcomID在200万张淘宝图像上训练,图像分辨率高,美学评分超过5.5,能生成与个体身份高度一致的图像。SDXL-EcomID适于虚拟现实、影视制作、身份验证等多个领…- 2

- 0

-

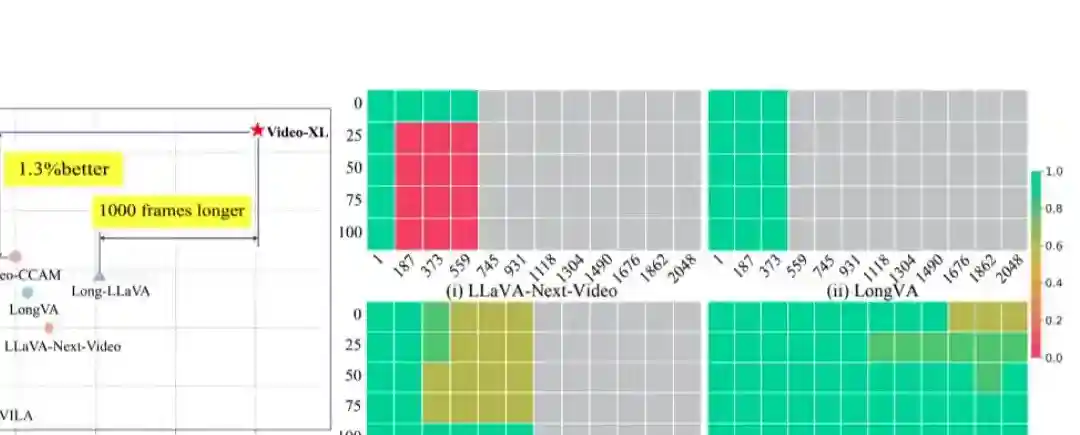

Video-XL – 智源联合多所高校推出的开源超长视觉理解模型

Video-XL项目简介 Video-XL是北京智源人工智能研究院联合上海交大、中国人民大学、中科院、北邮和北大的研究人员共同推出的专为小时级视频理解设计的超长视觉理解模型。基于视觉上下文潜在总结技术将视觉信息压缩成紧凑的形式,提高处理效率、减少信息丢失。在多个长视频理解基准测试中表现出色,例如在VNBench上准确率比现有最佳方法高出近10%,在单个80GB GPU上处理2048帧视频时,准确率…- 1

- 0

-

Filmfotos – 模拟和还原胶片质感效果的LoRA模型

Filmfotos项目简介 Filmfotos是由DynamicWang推出的的基于Flux架构的LoRA模型,专注于模拟和还原胶片的质感效果。以低饱和度的日系胶片风格为特点,为照片带来柔和、细腻的复古美感。Filmfotos适用于多种场景,包括人物、风景、静物、食物和动物等,在多种图像类型中表现出胶片特有的质感。基于Flux架构的强大性能和LoRA模型的灵活性,提供高精度的图像生成,适合追求胶片…- 2

- 0

-

Mureka O1 – 昆仑万维推出的音乐推理大模型

Mureka O1项目简介 Mureka O1是昆仑万维发布的全球首款音乐推理大模型,全球首个引入“思维链”(Chain of Thought,CoT)技术的音乐模型,Mureka O1在推理过程中加入思考与自我批判机制,大幅提升了音乐品质、创作效率和灵活性。支持纯音乐生成以及10种语言的AI音乐创作,涵盖多种音乐风格和情感表达,具备歌曲参考和音色克隆等特色功能。Mureka O1开放了API服务…- 0

- 0

-

Hunyuan3D 2.0 – 腾讯推出的大规模 3D 资产生成系统

Hunyuan3D 2.0项目简介 Hunyuan3D 2.0 是腾讯推出的大规模 3D 资产生成系统,专注于从文本和图像生成高分辨率的 3D 模型。系统采用两阶段生成流程:首先生成无纹理的几何模型,再合成高分辨率纹理贴图。包含两个核心组件:Hunyuan3D-DiT(几何生成模型)和 Hunyuan3D-Paint(纹理合成模型),分别用于生成精确的几何结构和生动逼真的纹理。 Hunyuan3D…- 3

- 0

-

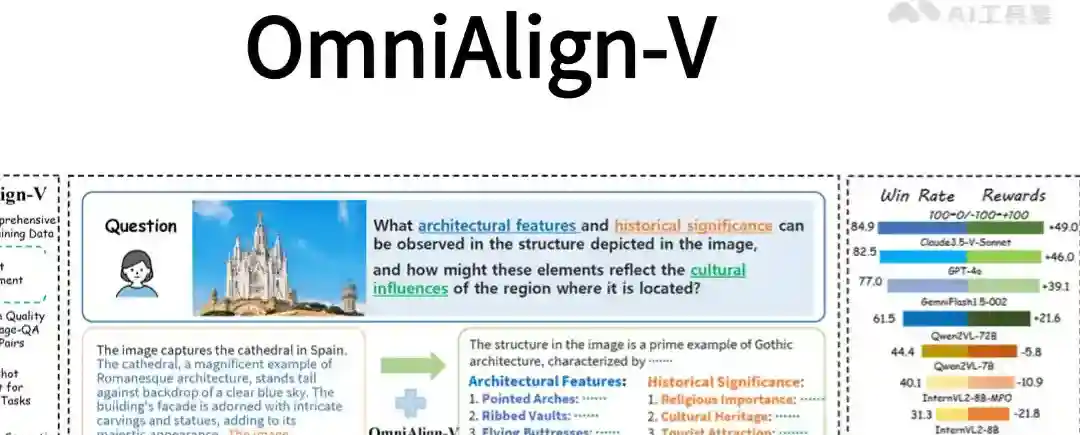

OmniAlign-V – 上海交大联合上海 AI Lab 等推出的高质量数据集

OmniAlign-V项目简介 OmniAlign-V 是上海交通大学、上海AI Lab、南京大学、复旦大学和浙江大学联合推出的专为提升多模态大语言模型(MLLMs)与人类偏好的对齐能力设计的高质量数据集。OmniAlign-V包含约20万个多模态训练样本,涵盖自然图像和信息图表,结合开放式、知识丰富的问答对。OmniAlign-V 的设计注重任务的多样性,包括知识问答、推理任务和创造性任务,基于…- 2

- 0

-

Adobe Firefly – Adobe推出的系列创意生成式AI模型

Adobe Firefly项目简介 Adobe Firefly 是 Adobe 推出的一系列创意生成式 AI 模型,旨在帮助用户扩展其天生的创造力。这些模型集成在 Adobe 的旗舰应用程序和 Adobe Stock 中,支持的功能包括图像、矢量图形和设计模型,以及最新的视频模型 。Firefly 通过简单的文字描述或其他输入,能够快速生成视频、文档、数字体验以及丰富的图像和艺术作品 。 Adob…- 0

- 0

-

DynVFX – AI视频增强技术,将新动态内容与原始视频无缝融合

DynVFX项目简介 DynVFX是创新的视频增强技术,能根据简单的文本指令将动态内容无缝集成到真实视频中。通过结合预训练的文本到视频扩散模型和视觉语言模型(VLM),实现了在不依赖复杂用户输入的情况下,自然地将新动态元素与原始视频场景融合。用户只需提供简短的文本指令,例如“添加一只在水中游泳的海豚”,DynVFX可自动解析指令,基于VLM生成详细的场景描述,通过锚点扩展注意力机制精准定位新内容的…- 0

- 0

-

SkyReels-V1 – 昆仑万维开源首个面向AI短剧创作的视频生成模型

SkyReels-V1项目简介 SkyReels-V1是昆仑万维开源的首个面向AI短剧创作的视频生成模型。基于在千万级高质量影视数据上进行微调,实现影视级的人物微表情和肢体动作生成,支持33种细腻表情与400多种自然动作组合,高度还原真实情感表达。模型支持文生视频(Text-to-Video),图生视频(Image-to-Video),在开源视频生成模型中达到SOTA水平。SkyReels-V1基…- 0

- 0

-

FLUX1.1 – Black Forest Labs团队推出的超写实AI图像生成模型,代号“蓝莓”

FLUX1.1项目简介 FLUX1.1 Pro是Black Forest Labs团队最新推出的升级版AI图像生成模型,代号“蓝莓”,提供比前代快6倍的生成速度,同时保持了图像的及时性和多样性。FLUX1.1目前仅包含FLUX1.1 Pro模型,预计后续会开放更多的系列模型,FLUX1.1 Pro通过API对外开放,主要面向开发者和企业用户。FLUX1.1 Pro的一个独特功能是支持通过模仿单反相…- 0

- 0

-

文心大模型X1 – 百度推出的深度思考模型

文心大模型X1项目简介 文心大模型X1是百度推出的深度思考模型。具备“长思维链”,擅长中文知识问答、文学创作、逻辑推理等。X1增加了多模态能力,能理解和生成图片,能调用工具生成代码、图表等丰富内容。基于递进式强化学习、思维链和行动链的端到端训练等关键技术,通过飞桨与文心的联合优化,大幅降低了推理成本。 文心大模型X1优势介绍 深度思考能力:作为深度思考模型,文心大模型X1具备“长思维链”,擅长中文…- 2

- 0

-

FLUX-Controlnet-Inpainting – 阿里妈妈推出的开源AI图像修复工具

FLUX-Controlnet-Inpainting项目简介 FLUX-Controlnet-Inpainting 是阿里妈妈(Alibaba’s Alimama)推出的一款图像修复工具,融合 ControlNet 和 FLUX.1-dev 技术。工具根据用户指定的掩码区域进行精确的图像修复,确保修复部分与原图风格一致。FLUX-Controlnet-Inpainting基于 ControlNet…- 3

- 0

-

Amazon Nova – 亚马逊推出的全新大模型系列,覆盖文本、图像、视频生成领域

Amazon Nova项目简介 Amazon Nova 是亚马逊云服务(AWS)推出的新一代AI基础模型系列,提供行业领先的性能和成本效益。系列包括专门处理文本的Amazon Nova Micro、多模态的Amazon Nova Lite 和Amazon Nova Pro,Amazon Nova Premier。图像生成模型Amazon Nova Canvas 和视频生成模型Amazon Nova…- 1

- 0