-

ASAP – 卡内基梅隆大学联合英伟达推出的模拟与真实物理对齐框架

ASAP项目简介 ASAP(Aligning Simulation and Real Physics)是卡内基梅隆大学和英伟达联合推出的,用在解决仿人机器人模拟与现实动力学不匹配问题的两阶段框架。ASAP基于预训练阶段在模拟环境中学习运动跟踪策略,用人类运动数据生成目标动作。在后训练阶段,ASAP收集真实世界的运动数据,训练Delta动作模型补偿模拟与现实之间的动力学差异,基于微调策略使其适应真实…- 0

- 0

-

英伟达与港大携手推出新型视觉注意力机制,提升高分辨率生成速度超 84 倍!

近日,香港大学与英伟达共同研发了一种新的视觉注意力机制,名为广义空间传播网络(GSPN),该机制在高分辨率图像生成方面取得了显著的突破。 传统的自注意力机制虽然在自然语言处理和计算机视觉领域取得了不错的效果,但在处理高分辨率图像时却面临计算量巨大和空间结构损失的双重挑战。传统的自注意力机制的计算复杂度为 O (N²),这使得处理长上下文时非常耗时,并且将二维图像转化为一维序列会导致空间关系的丢失。…- 3

- 0

-

Sana – 英伟达、麻省和清华联合推出的文本到图像生成框架

Sana项目简介 SANA是由NVIDIA、麻省理工学院和清华大学共同推出的文本到图像生成框架,能高效地生成高达4096×4096分辨率的高清晰度图像。SANA基于深度压缩自编码器、线性扩散变换器(Linear DiT)、仅解码器的小型语言模型作为文本编码器,和高效的训练和采样策略,实现快速生成具有强文本图像对齐的高分辨率图像。SANA在模型大小和吞吐量上具有显著优势,能在笔记本电脑GPU上快速部…- 0

- 0

-

LongVILA – 面向长视频理解的视觉语言AI模型

LongVILA项目简介 LongVILA是一个面向长视频理解的视觉语言AI模型,由英伟达、MIT、UC 伯克利、得克萨斯大学奥斯汀分校共同开发。通过算法和系统的共同设计,实现了在大量GPU上进行超长上下文长度训练的能力,无需梯度检查点。LongVILA能将视频帧数扩展至1024,显著提升了长视频字幕的评分,并在大规模视频字幕任务中实现了99.5%的准确率。还引入了多模态序列并行性(MM-SP)系…- 1

- 0

-

显存优化!英伟达 DLSS 4 让游戏更流畅,Transformer 模型显存减少 20%

在游戏性能日益提升的今天,英伟达再次引领了显卡技术的潮流。最新发布的 DLSS4SDK,不仅正式上线,还在显存(VRAM)的使用上进行了重大优化,让玩家们在享受高质量游戏画面的同时,显卡的负担也大大减轻。 根据相关报道,英伟达在最新的 DLSS310.3.0版本中,对 Transformer 模型的显存占用进行了20% 的优化。之前,DLSS 的 Transformer 模型在显存使用上几乎是传统…- 3

- 0

-

APB – 清华联合腾讯等机构推出的分布式长上下文推理框架

APB项目简介 APB(Accelerating Distributed Long-Context Inference by Passing Compressed Context Blocks across GPUs)是清华大学等机构联合提出的分布式长上下文推理框架。通过稀疏注意力机制和序列并行推理方式,有效解决了大模型处理长文本时的效率瓶颈。APB采用更小的Anchor block和Passin…- 2

- 0

-

Parakeet TDT 0.6B – 英伟达开源的自动语音识别模型

Parakeet TDT 0.6B项目简介 Parakeet TDT 0.6B 是英伟达推出的开源自动语音识别(ASR)模型。采用FastConformer编码器和TDT解码器架构,通过预测文本标记及其持续时间加速推理,减少计算开销。模型在1秒内可转录60分钟音频,实时因子(RTFx)达3386,平均单词错误率(WER)仅为6.05%,在LibriSpeech-clean数据集上WER低至1.69…- 2

- 0

-

Eagle 2.5 – 英伟达推出的视觉语言模型

Eagle 2.5项目简介 Eagle 2.5是英伟达推出的视觉语言模型,专注于长上下文多模态学习的 AI 模型,参数规模仅为 8B。参数量较小,但在处理高分辨率图像和长视频序列方面表现出色,性能媲美参数量更大的 Qwen 2.5-VL-72B 和 InternVL2.5-78B。Eagle 2.5 采用创新训练策略:信息优先采样和渐进式后训练。信息优先采样通过图像区域保留和自动降级采样技术,确保…- 0

- 0

-

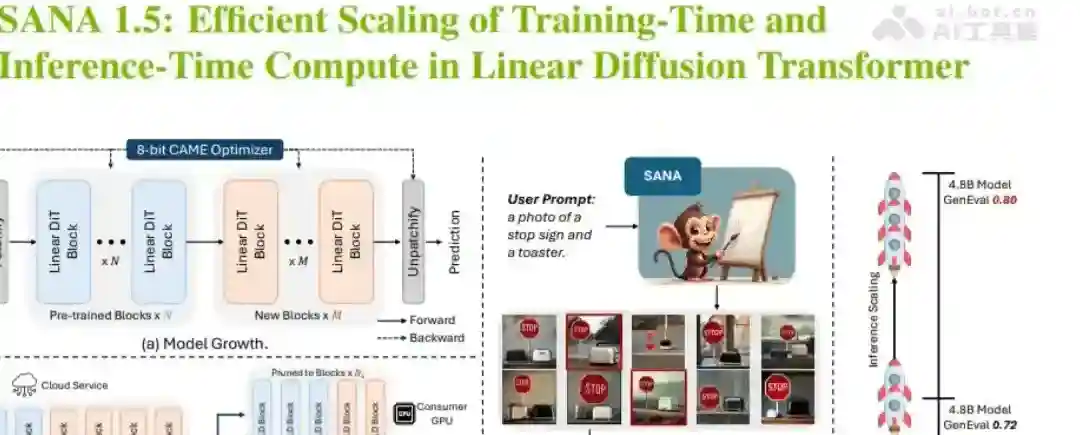

SANA 1.5 – 英伟联合MIT、清北等机构推出的文生图新框架

SANA 1.5项目简介 SANA 1.5是英伟达联合MIT、清华、北大等机构推出的新型高效的线性扩散变换器(Linear Diffusion Transformer),用于文本到图像生成任务。在 SANA 1.0 的基础上进行了改进,提出了三大创新点:高效的训练扩展,通过深度增长范式,将模型从 16 亿参数扩展到 48 亿参数,显著减少计算资源,结合了高效的 8 位优化器。模型深度剪枝,通过分析…- 2

- 0

-

NeMo – 英伟达推出的用于构建、定制和部署生成式AI模型

NeMo项目简介 NeMo 是由 NVIDIA 提供的端到端云原生框架,用于构建、定制和部署生成式 AI 模型。支持大型语言模型(LLMs)、多模态模型、语音识别和文本转语音(TTS)等应用。NeMo 的设计理念强调模块化和灵活性,使研究人员和企业用户能根据自己的需求选择和定制相应的AI模块。基于深度学习框架,基于优化的算法和技术,提供多模态融合能力,适用于金融、医疗、教育等多个行业,支持分布式训…- 0

- 0

-

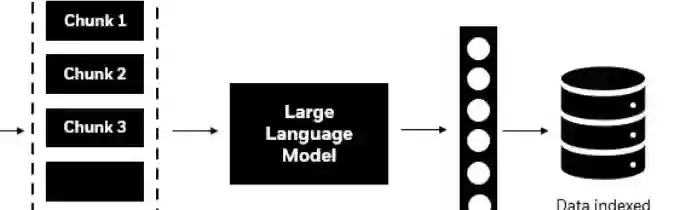

HybridRAG – 黑石联合英伟达推出的混合检索增强生成架构

HybridRAG项目简介 HybridRAG 是黑石联合英伟达推出的混合检索增强生成架构,结合了检索增强生成(Retrieval-Augmented Generation)模型的机器学习架构。模型通过检索系统寻找与输入相关的信息,然后将这些信息与输入一起输入到生成模型中,生成更准确和丰富的输出。HybridRAG在问答、摘要和对话生成等自然语言处理任务中表现出色,能用大量外部知识,提高生成内容的…- 6

- 0

-

LLaMA-Mesh – 清华联合英伟达推出的自然语言生成复杂的3D模型项目

LLaMA-Mesh项目简介 LLaMA-Mesh是清华大学和NVIDIA共同推出的项目,基于将3D网格生成与大型语言模型(LLMs)结合,实现用文本提示直接生成3D模型的功能。项目用OBJ文件格式将3D网格的顶点坐标和面定义转换为文本,基于顶点量化技术优化处理,让模型能理解和生成3D网格。LLaMA-Mesh能生成高质量的3D网格,保持强大的语言理解和生成能力,为3D内容创作提供一种更直观、高效…- 3

- 0

-

NVLM – 英伟达推出的多模态大型语言模型

NVLM项目简介 NVLM是NVIDIA推出的前沿多模态大型语言模型(LLMs),在视觉-语言任务上达到与顶尖专有模型(如GPT-4o)和开放访问模型(如Llama 3-V 405B和InternVL 2)相匹敌的性能。NVLM 1.0家族包括三种架构:仅解码器模型NVLM-D、基于交叉注意力的模型NVLM-X和混合架构NVLM-H。三种架构在多模态训练后,保持了文本性能,在某些情况下超过了它们的…- 0

- 0

-

英伟达董事马克・史蒂文斯一周内抛售超过百万股股票

英伟达公司(Nvidia Corp.)的董事马克・史蒂文斯(Mark Stevens)本周内出售了超过一百万股公司的股票,交易的总价值接近1.5亿美元。这一举动发生在英伟达股票经历了一段时间的波动后,最近的股价有所回升。根据美国证券交易委员会(SEC)周三公布的文件,史蒂文斯的股票销售分为两个交易,分别在周一和周二进行。 随着英伟达在市场上的表现逐渐改善,史蒂文斯的这笔交易引起了投资者的广泛关注。…- 0

- 0

-

赤兔Chitu – 清华联合清程极智开源的大模型推理引擎

Chitu项目简介 Chitu(赤兔)是清华大学高性能计算研究所与清程极智联合开源的高性能大模型推理引擎,专为解决大模型在推理阶段的高成本和低效率问题设计,具有强大的硬件适配能力,支持英伟达多款GPU及国产芯片,打破了对特定硬件(如英伟达Hopper架构)的依赖。 在性能方面,在A800集群上部署DeepSeek-R1-671B时,相比部分国外开源框架,GPU使用量减少50%,推理速度提升3.15…- 3

- 0

-

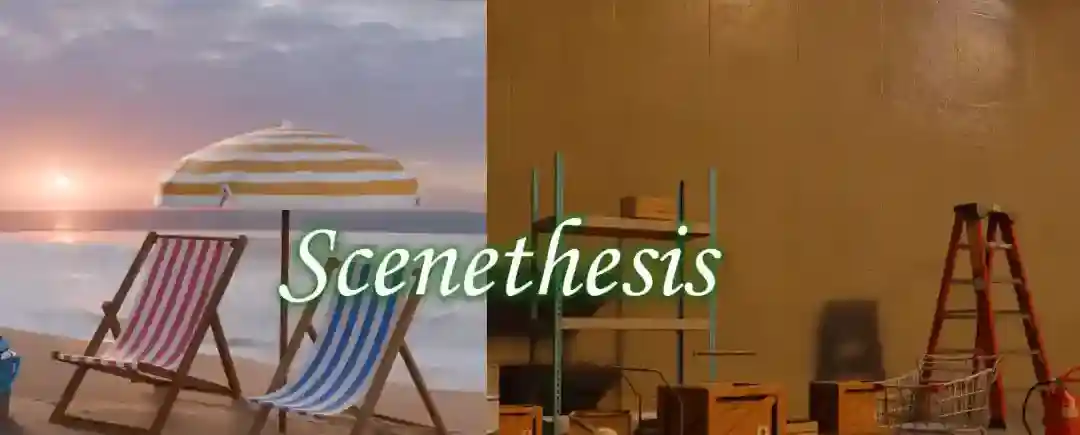

Scenethesis – 英伟达推出的交互式3D场景生成框架

Scenethesis项目简介 Scenethesis 是 NVIDIA 推出的创新框架,用在从文本生成交互式 3D 场景。框架结合大型语言模型(LLM)和视觉感知技术,基于多阶段流程实现高效生成,用 LLM 进行粗略布局规划,基于视觉模块细化布局生成图像指导,用优化模块调整物体姿态确保物理合理性,基于判断模块验证场景的空间连贯性。Scenethesis 能生成多样化的室内外场景,具有高度的真实感…- 6

- 0

-

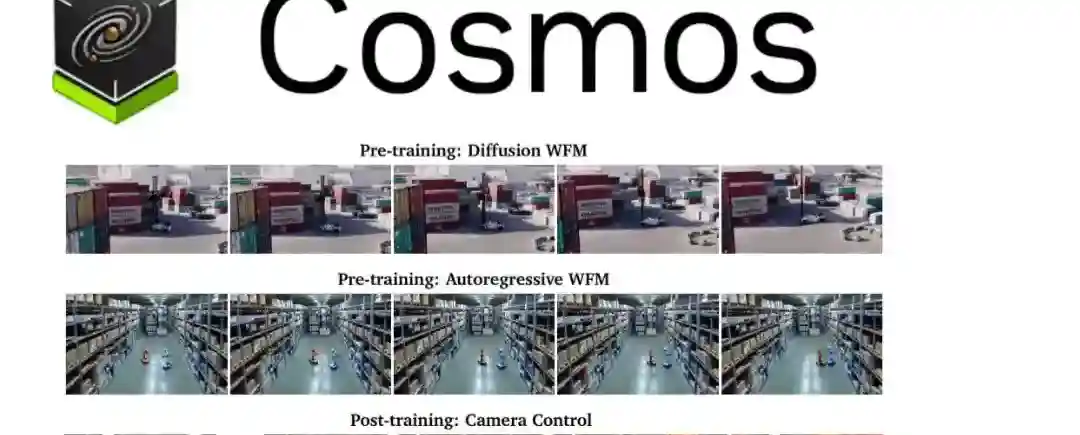

Cosmos – 英伟达推出的生成式世界基础模型平台

Cosmos项目简介 Cosmos是英伟达推出的生成式世界基础模型平台,加速物理人工智能(AI)系统的发展,特别是在自动驾驶和机器人领域。Cosmos能接受文本、图像或视频的提示,生成高度仿真的虚拟世界状态,为自动驾驶和机器人应用提供独特的视频输出。平台集成了生成式世界基础模型、高级标记器和加速视频处理管道,帮助开发者生成大量基于物理的合成数据,减少对真实世界数据的依赖。Cosmos还提供了安全防…- 2

- 0

-

英伟达与MIT合作推出 Fast-dLLM 框架,AI 推理速度提升 27.6 倍

近日,科技巨头英伟达联合麻省理工学院(MIT)与香港大学,发布了名为 Fast-dLLM 的新框架。这一创新的框架旨在显著提高扩散模型(Diffusion-based LLMs)的推理速度,最高可达27.6倍,为人工智能的应用提供了更为强大的技术支持。 扩散模型的挑战与机遇 扩散模型被视为传统自回归模型(Autoregressive Models)的有力竞争者。它采用双向注意力机制(Bidire…- 2

- 0

-

Llama-3.1-Minitron – 英伟达联合Meta推出的Llama 3.1 4B参数模型

Llama-3.1-Minitron项目简介 Llama-3.1-Minitron是由英伟达和Meta合作开发的AI模型,通过剪枝和知识蒸馏技术从Llama 3.1 8B模型精炼而成的更小型4B参数模型。这种优化减少了模型大小和复杂性,同时保持了核心性能。Llama-3.1-Minitron 4B在多个基准测试中表现优异,与更大模型相比具有竞争力,且在FP8精度下吞吐量提升显著,是AI绘画和写作等…- 3

- 0

-

互联网女皇AI趋势报告:AI模型训练成本超高,但推理成本断崖式下降

根据互联网女皇发布的AI趋势报告的深度分析,人工智能(AI)模型的计算经济学正经历着一场关键的转变。报告指出,训练最强大的大型语言模型(LLM)已成为人类历史上最昂贵、资本最密集的投入之一,目前每个模型的训练成本往往超过1亿美元。Anthropic首席执行官Dario Amodei在2024年中指出,目前有模型正在训练,其成本接近10亿美元,并预测到2025年,训练成本高达100亿美元的模型可能会…- 1

- 0