-

Mogao – 字节跳动Seed团队推出的多模态理解与生成统一架构

Mogao项目简介 Mogao是字节跳动Seed团队推出的交错多模态生成全基础模型。在架构上采用了双视觉编码器,结合变分自编码器(VAE)和视觉变换器(ViT),能更好地进行视觉理解并改善图像生成的上下文对齐。Mogao引入了交错旋转位置嵌入(IL-RoPE),用于捕捉图像的二维空间位置信息和多模态数据的时间位置关系,通过多模态无分类器引导技术进一步提升生成质量和一致性。 Mogao优势介绍 多模…- 0

- 0

-

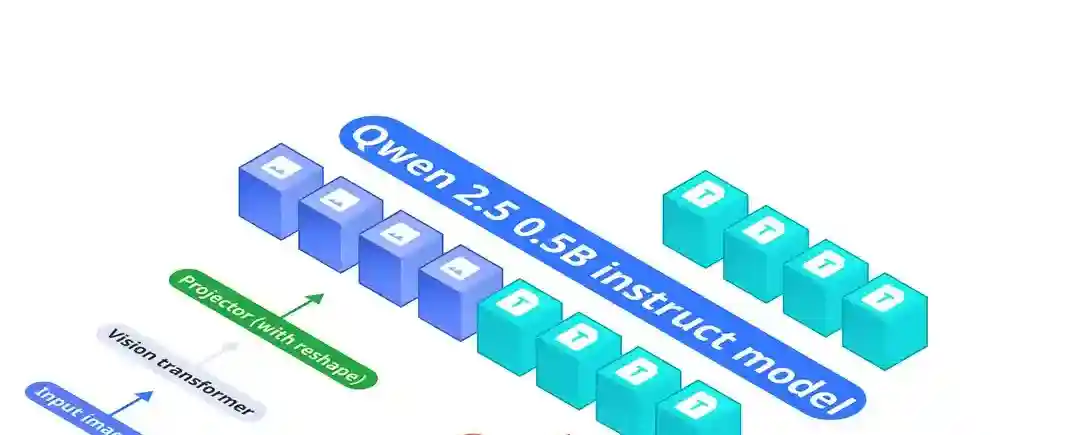

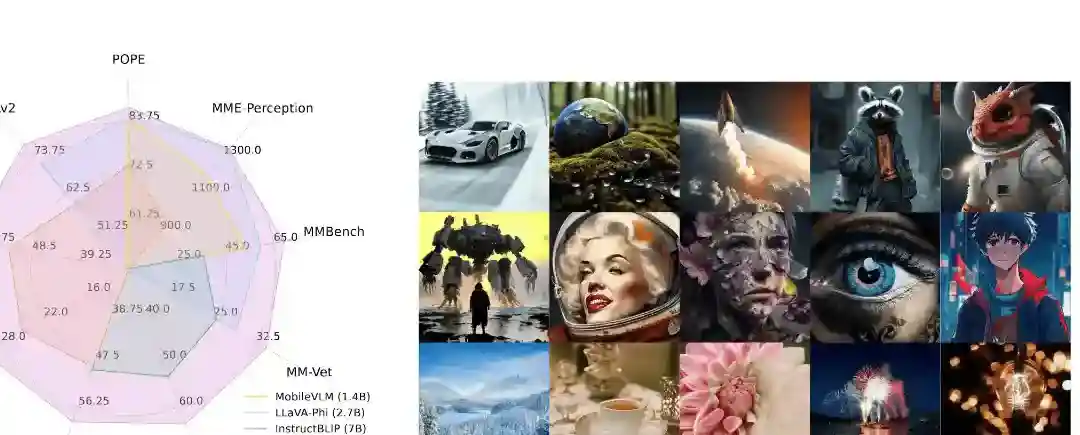

OmniVision – 专为边缘设备优化的最小参数多模态模型

OmniVision项目简介 OmniVision是紧凑的多模态模型,拥有968M参数,专为边缘设备优化。OmniVision能处理视觉和文本输入,基于LLaVA架构改进,显著减少图像token数量,降低延迟和计算成本。基于可信数据进行DPO训练,OmniVision提供更可靠的结果,适于视觉问答和图像描述等任务。 OmniVision优势介绍 视觉问答(Visual Question Answe…- 0

- 0

-

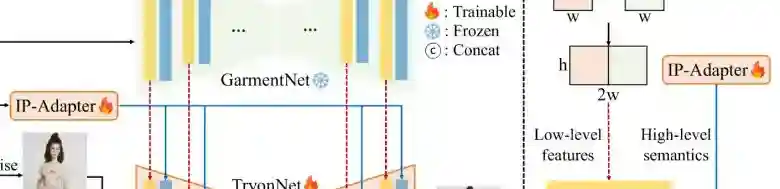

IDM-VTON – 逼真的开源AI虚拟试穿框架

IDM-VTON项目简介 IDM-VTON(Improved Diffusion Models for Virtual Try-ON)是由韩国科学技术院和OMNIOUS.AI的研究人员提出的一种先进的AI虚拟试穿技术,通过改进扩散模型来生成逼真的人物穿戴图像,实现更真实的虚拟试穿效果。该技术包含两个关键组件:一是视觉编码器,用于提取服装图像的高级语义信息;二是GarmentNet,一个并行UNet…- 0

- 0

-

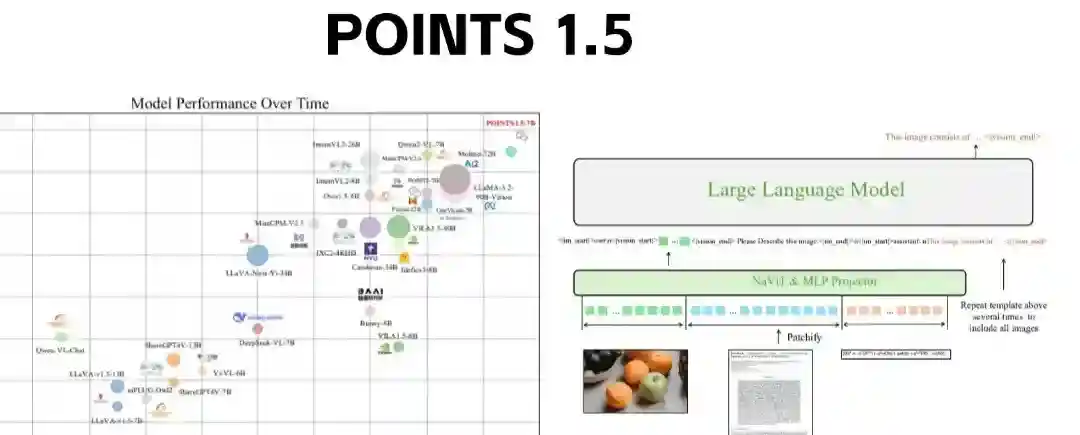

POINTS 1.5 – 腾讯微信推出的多模态大模型

POINTS 1.5项目简介 POINTS 1.5 是腾讯微信发布的多模态大模型,是POINTS 1.0的升级版本。 模型继续沿用了POINTS 1.0中的LLaVA架构,由一个视觉编码器、一个投影器和一个大型语言模型组成。 POINTS 1.5在效率和性能上都进行了增强,特别是在全球10B以下开源模型的排名中,POINTS 1.5-7B位居榜首,超越了其他业界领先的模型,如Qwen2-VL、In…- 0

- 0

-

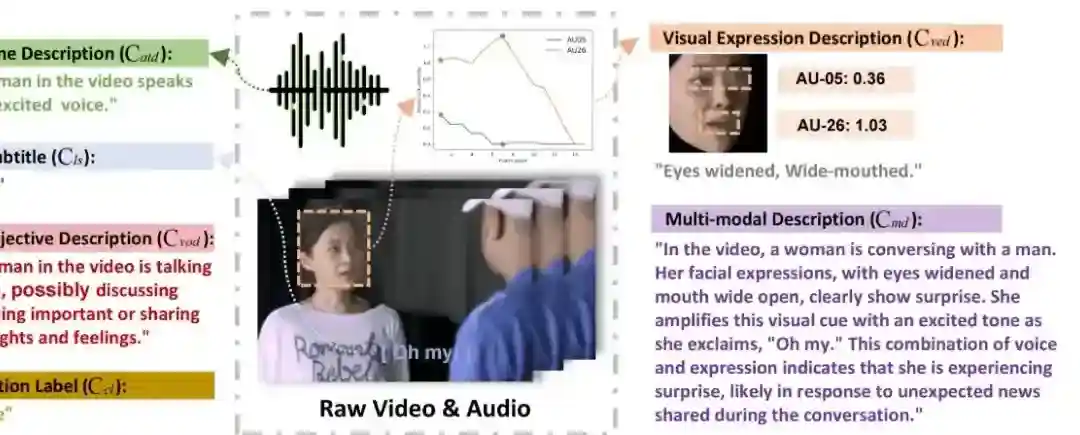

Emotion-LLaMA – 多模态情绪识别与推理模型,融合音频、视觉和文本输入

Emotion-LLaMA项目简介 Emotion-LLaMA是多模态情绪识别与推理模型,融合了音频、视觉和文本输入,通过特定情绪编码器整合信息。模型基于修改版LLaMA,经指令调整以提升情感识别能力。研究者构建了MERR数据集助力训练与评估,使模型能从多场景学习并应用于现实。Emotion-LLaMA在多个数据集和挑战赛中表现优异,如在MER2024挑战赛MER-NOISE赛道中以84.52%的…- 1

- 0

-

Janus – DeepSeek推出的自回归框架,统一多模态理解和生成任务

Janus项目简介 Janus是一个由DeepSeek AI推出的自回归框架,旨在统一多模态理解和生成任务。将视觉编码分离成不同的路径解决以往方法的局限性,且用单一的变换器架构进行处理。减轻视觉编码器在理解和生成任务中的角色冲突,提高框架的灵活性。Janus在性能上超越以往的统一模型,在某些情况下超过特定任务模型的性能。Janus的设计支持未来能轻松集成更多类型的输入模态,如点云、EEG信号或音频…- 0

- 0

-

Seed1.5-VL – 字节跳动Seed推出的视觉语言多模态大模型

Seed1.5-VL项目简介 Seed1.5-VL 是字节跳动 Seed 团队最新发布的视觉-语言多模态大模型,具备强大的通用多模态理解和推理能力,推理成本显著降低。模型由一个 532M 参数的视觉编码器和一个 20B 活动参数的混合专家(MoE)LLM 组成。在 60 个公开评测基准中的 38 个上取得了最佳表现,在交互式代理任务中也优于 OpenAI CUA 和 Claude 3.7 等领先的…- 0

- 0

-

PP-TableMagic – 百度飞桨团队开源的表格识别工具

PP-TableMagic项目简介 PP-TableMagic 是百度飞桨团队推出的高性能表格识别工具,用在将图片中的表格结构化信息提取出来,转换为 HTML 等格式,进行进一步的数据处理和分析。PP-TableMagic 用自研的轻量级表格分类模型 PP-LCNet 和业界首个开源单元格检测模型 RT-DETR,及强大的表格结构识别模型 SLANeXt,结合三阶段预训练策略,提升表格识别的精度和…- 0

- 0

-

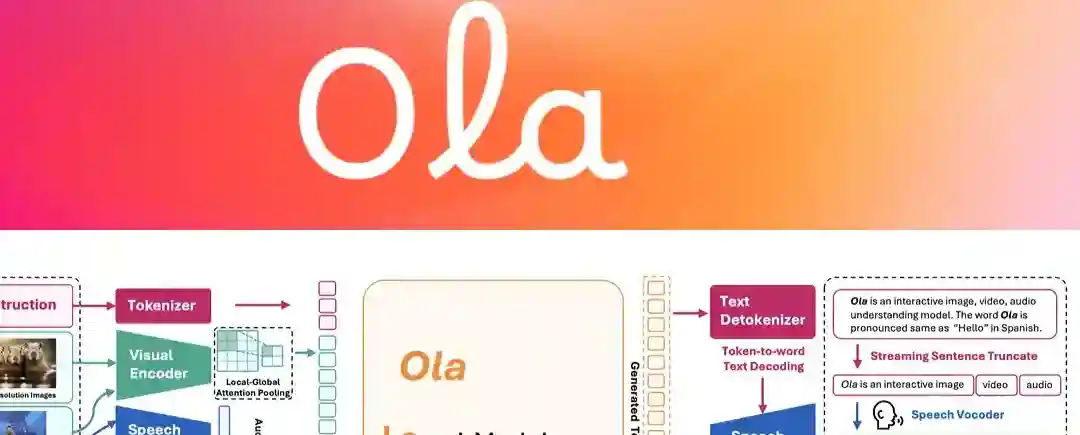

Ola – 清华联合腾讯等推出的全模态语言模型

Ola项目简介 Ola是清华大学、腾讯 Hunyuan 研究团队和新加坡国立大学 S-Lab 合作开发的全模态语言模型。通过渐进式模态对齐策略,逐步扩展语言模型支持的模态,从图像和文本开始,再引入语音和视频数据,实现对多种模态的理解。Ola 的架构支持全模态输入,包括文本、图像、视频和音频,能同时处理这些输入。Ola 设计了逐句解码方案用于流式语音生成,提升交互体验。 Ola优势介绍 多模态理解:…- 1

- 0

-

Phantom – 字节跳动推出的主体一致视频生成框架

Phantom项目简介 Phantom是字节跳动智能创作团队推出的用在主体一致视频生成(Subject-to-Video, S2V)的框架。基于跨模态对齐技术,结合文本和图像提示,从参考图像中提取主体元素并生成与文本描述一致的视频内容。Phantom基于现有的文本到视频(T2V)和图像到视频(I2V)架构,重新设计了联合文本-图像注入模型,基于文本-图像-视频三元组数据学习跨模态对齐。Phanto…- 2

- 0

-

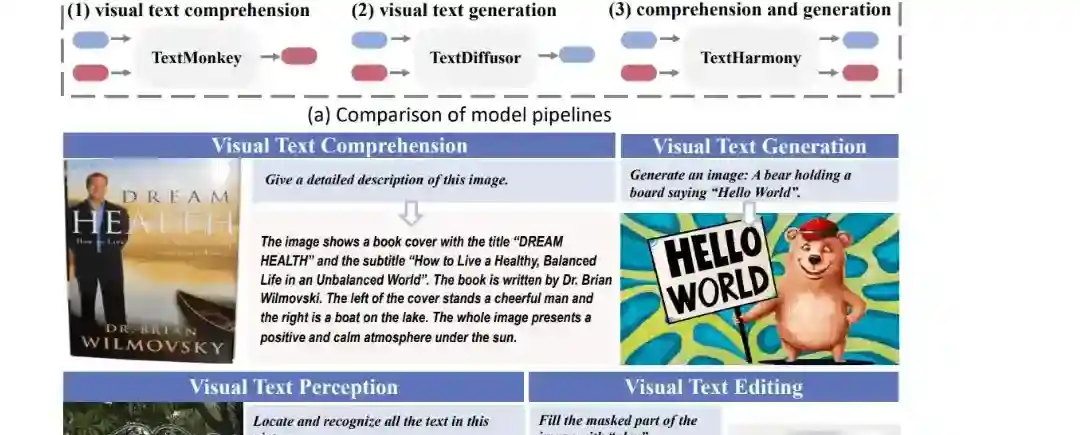

TextHarmony – 字节联合华东师范推出的多模态生成模型

TextHarmony项目简介 TextHarmony是华东师范大学和字节跳动共同推出的多模态生成模型,擅长理解和生成视觉文本。模型基于Slide-LoRA技术,动态聚合特定于模态和模态无关的LoRA专家,部分解耦多模态生成空间,在单一模型实例中协调视觉和语言的生成。TextHarmony在视觉和语言模态之间实现更统一的生成过程。研究团队推出高质量的图像字幕数据集DetailedTextCaps-…- 2

- 0

-

Ovis2 – 阿里国际推出的多模态大语言系列模型

Ovis2项目简介 Ovis2 是阿里巴巴国际团队推出的新型多模态大语言模型,基于结构化嵌入对齐解决视觉与文本模态间的差异。Ovis2继承、优化了 Ovis 系列架构,强化小规模模型的能力密度,基于指令微调和偏好学习显著提升了思维链(CoT)推理能力。Ovis2 引入视频和多图像处理能力,增强多语言支持和复杂场景下的 OCR 能力。Ovis2 系列包含1B、2B、4B、8B、16B 和 34B 六…- 1

- 0