-

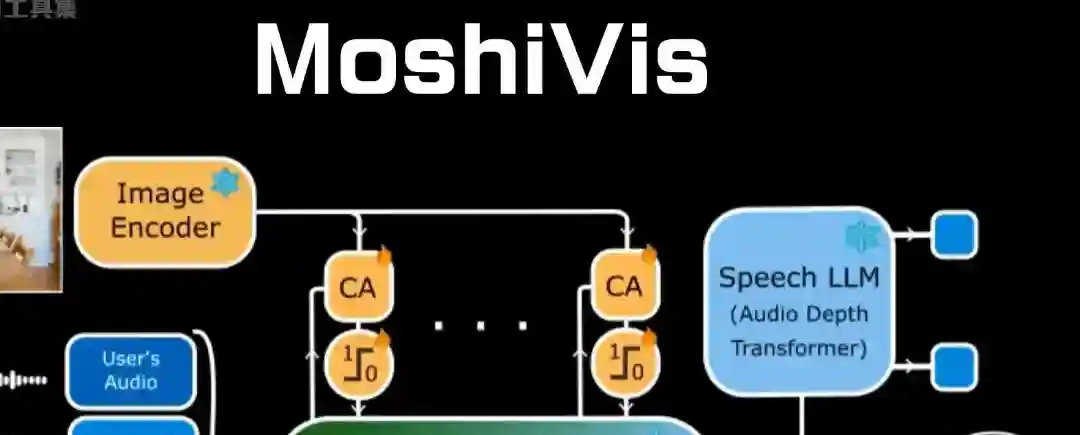

MoshiVis – Kyutai 开源的多模态实时语音模型

MoshiVis项目简介 MoshiVis 是 Kyutai 推出的开源多模态语音模型,基于 Moshi 实时对话语音模型开发,增加了视觉输入功能。能实现图像的自然、实时语音交互,将语音和视觉信息相结合,让用户可以通过语音与模型交流图像内容。模型在 Moshi 的 7B 基础架构上,增加了约 206M 的适配器参数,集成了 400M 的 PaliGemma2 视觉编码器。通过跨注意力机制和门控机制…- 3

-

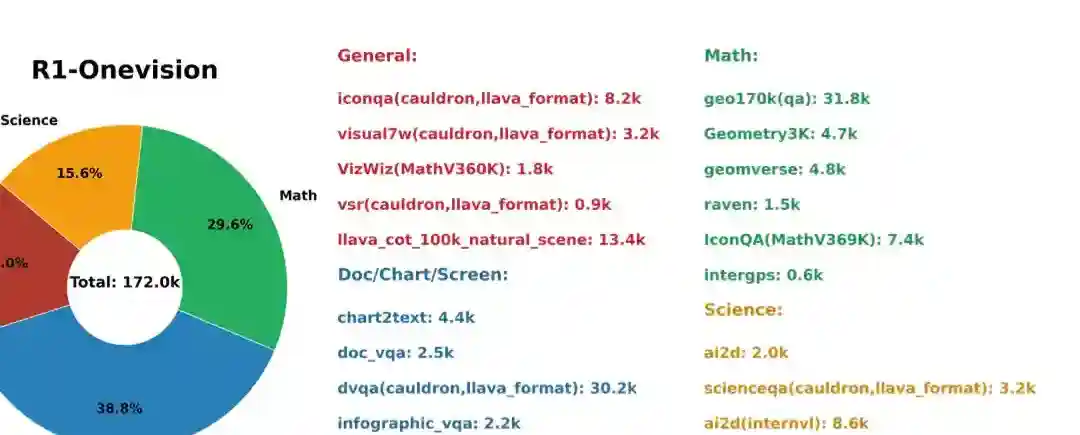

R1-Onevision – 开源多模态视觉推理模型,基于 Qwen2.5-VL 微调

R1-Onevision项目简介 R1-Onevision 是开源的多模态大语言模型,专注于复杂视觉推理任务。基于 Qwen2.5-VL 微调而成,通过整合视觉和文本数据,能精准地进行多模态信息解释。在数学、科学、深度图像理解和逻辑推理等领域表现出色,在多项推理基准测试中超越了 Qwen2.5-VL-7B 和 GPT-4V 等模型。 能同时处理图像和文本输入,通过先进的 embedding 技术实…- 4

-

AI绘画Stable Diffusion生成案例归隐山林

AI绘画工具:Stable Diffusion 工具介绍:Stable Diffusion 是一种基于扩散过程的图像生成模型,可以生成高质量、高分辨率的图像。它通过模拟扩散过程,将噪声图像逐渐转化为目标图像。这种模型具有较强的稳定性和可控性,可以生成具有多样化效果和良好视觉效果的图像。 工具链接::https://www.aieva.cn/sites/411.html 这篇文章主要是给大家展示,如…- 3

-

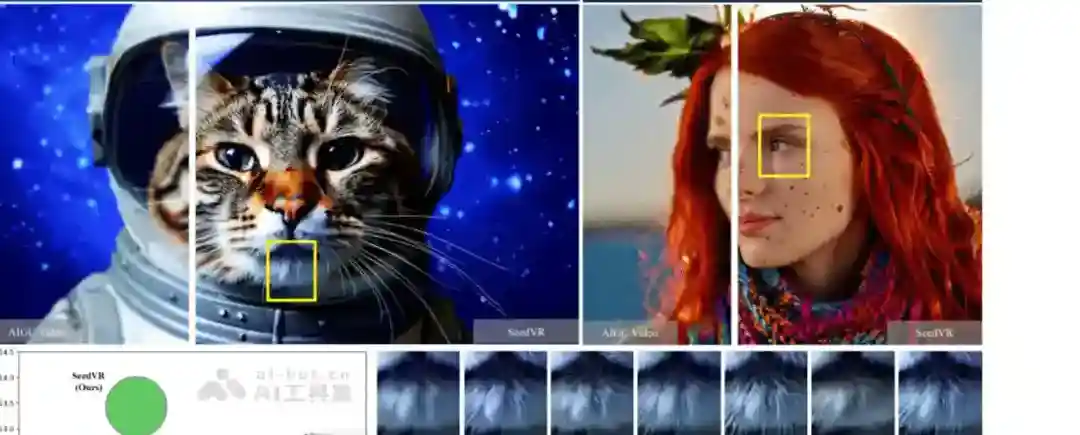

SeedVR – 南洋理工和字节跳动推出的扩散变换器模型,实现通用视频修复

SeedVR项目简介 SeedVR是南洋理工大学和字节跳动推出的扩散变换器模型,能实现高质量的通用视频修复。SeedVR基于引入移位窗口注意力机制,采用大尺寸(64×64)窗口和边界处的可变大小窗口,有效处理任意长度和分辨率的视频,克服传统方法在不同分辨率下的性能限制。SeedVR结合因果视频变分自编码器(CVVAE),基于时间和空间压缩降低计算成本,同时保持高重建质量。基于大规模图像和视频联合训…- 1

-

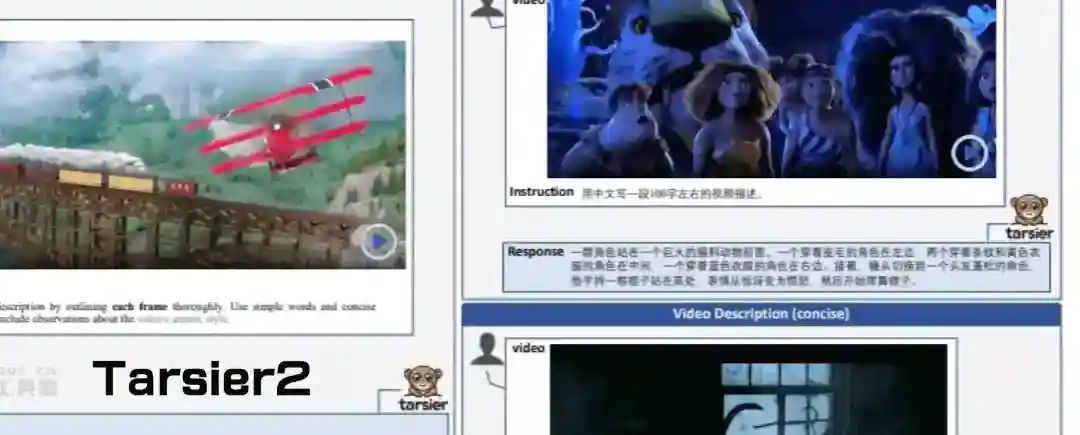

Tarsier2 – 字节跳动推出的视觉理解大模型

Tarsier2项目简介 Tarsier2是字节跳动推出的先进的大规模视觉语言模型(LVLM),生成详细且准确的视频描述,在多种视频理解任务中表现出色。模型通过三个关键升级实现性能提升,将预训练数据从1100万扩展到4000万视频文本对,丰富了数据量和多样性;在监督微调阶段执行精细的时间对齐;基于模型采样自动构建偏好数据,应用直接偏好优化(DPO)训练。 在DREAM-1K基准测试中,Tarsie…- 0

-

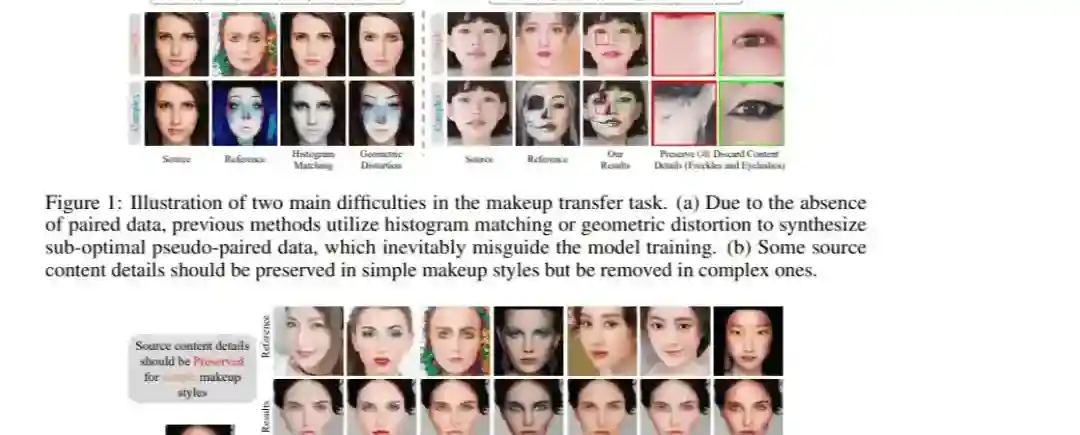

SHMT – 阿里达摩院联合武汉理工等机构推出的自监督化妆转移技术

SHMT项目简介 SHMT(Self-supervised Hierarchical Makeup Transfer)是阿里巴巴达摩院与武汉理工大学等机构联合研发的先进自监督化妆转移技术。技术通过潜在扩散模型实现,能在无需成对训练数据的情况下,将各种化妆风格自然地应用到目标面部图像上。SHMT采用“解耦-重建”策略,结合拉普拉斯金字塔和迭代双重对齐模块,实现了对不同化妆风格下纹理细节的灵活控制和对…- 1

-

auto-video-generator – AI自动解说视频生成器

auto-video-generator项目简介 auto-video-generator是AI自动解说视频生成器,能实现一键生成解说视频。用户只需输入主题,系统便自动撰写脚本、合成语音、生成图片并合成视频,极大提升内容创作效率。适用于自媒体、营销、教育等多个场景,帮助创作者快速制作高质量视频。 auto-video-generator的功能特色 自动生成解说脚本:输入主题后,AI自动撰写清晰、完…- 0

-

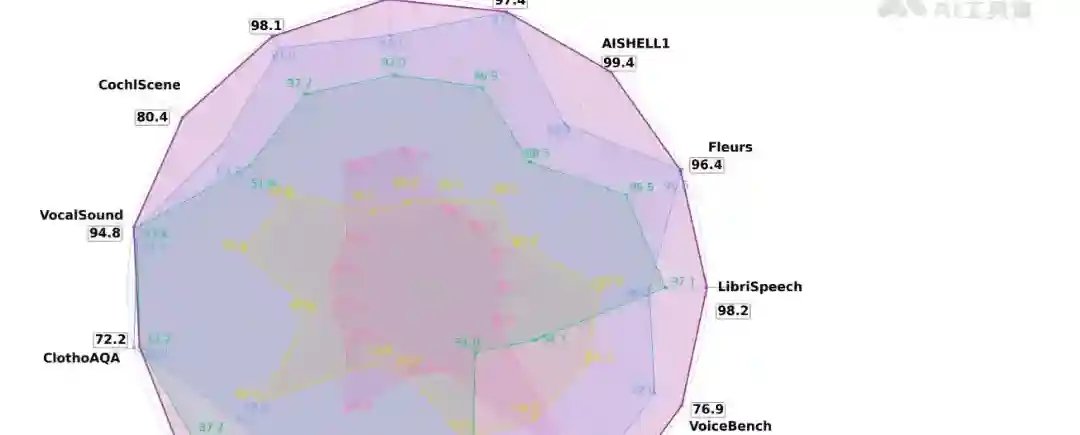

Kimi-Audio – Moonshot AI 开源的音频基础模型

Kimi-Audio项目简介 Kimi-Audio 是 Moonshot AI 推出的开源音频基础模型,专注于音频理解、生成和对话任务。在超过 1300 万小时的多样化音频数据上进行预训练,具备强大的音频推理和语言理解能力。核心架构采用混合音频输入(连续声学 + 离散语义标记),结合基于 LLM 的设计,支持并行生成文本和音频标记,同时通过分块流式解码器实现低延迟音频生成。 Kimi-Audio优…- 0