NMT项目简介

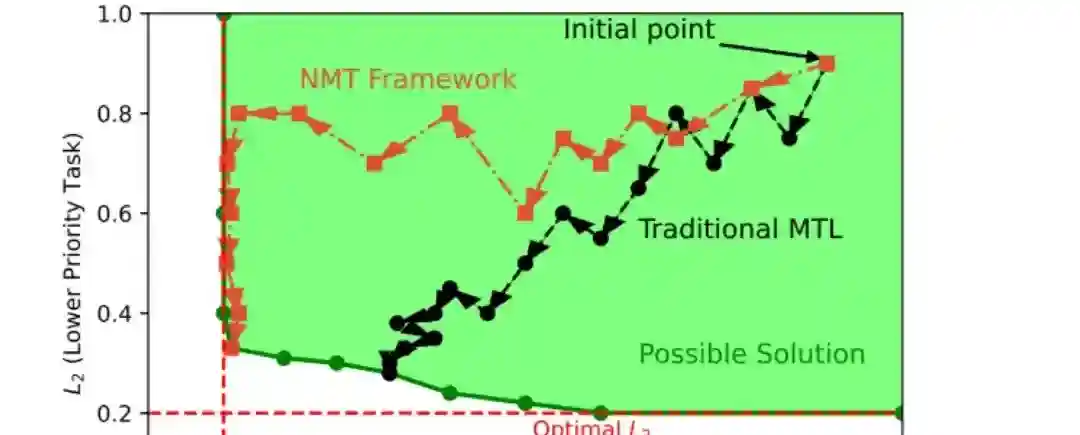

NMT(No More Tuning)是UC Berkeley和阿里巴巴集团联合推出的多任务学习框架,能解决多任务学习中不同任务优先级优化的问题。NMT将多任务学习问题转化为约束优化问题,将高优先级任务的性能作为约束条件,在优化低优先级任务时保持高优先级任务的性能。NMT基于拉格朗日微分乘数法,将约束问题转化为无约束问题,并用梯度下降法求解,避免传统方法中复杂的超参数调整过程。NMT框架易于与基于梯度下降的多任务学习方法集成,无需额外的超参数,有效简化模型训练过程,提高了高优先级任务的性能。

NMT优势介绍

任务优先级优化:NMT框架能根据任务的优先级进行优化,确保在优化次要任务时,高优先级任务的性能不会受到影响,实现多任务学习中不同任务之间的有效平衡。

简化超参数调整:将任务优先级直接嵌入优化问题的约束中,NMT框架消除了传统多任务学习方法中对超参数进行手动调整的需求,简化了模型训练过程,降低因参数设置不当导致的次优性能风险。

易于集成与扩展:无缝集成到现有的基于梯度下降的多任务学习方法中,无需对原有架构进行大规模修改,具有良好的兼容性和扩展性。

理论性能保障:在一定假设条件下,NMT框架能提供优化过程的理论保障,确保高优先级任务的性能优化符合预期,增强模型训练的可靠性和稳定性。

NMT详细报告

约束优化问题转化:将多任务学习问题转化为约束优化问题,将高优先级任务的性能作为不等式约束条件,要求在优化低优先级任务时,高优先级任务的性能不低于最优值。

拉格朗日乘数法应用:用拉格朗日乘数法,将约束优化问题转化为无约束问题。基于引入拉格朗日乘数,将约束条件融入目标函数中,形成拉格朗日函数,将问题转化为求解拉格朗日函数的优化问题。

梯度下降与上升结合:采用梯度下降法对模型参数进行优化,用最小化目标函数;同时,用梯度上升法对拉格朗日乘数进行更新,满足约束条件的最大化要求。这种结合使用梯度下降和上升的方法,让NMT能在优化过程中兼顾任务优先级和性能约束。

逐步优化策略:基于逐步优化的策略,首先优化最高优先级的任务,获得最优解;然后在保持高优先级任务性能不变的前提下,依次优化其他低优先级任务。这种策略确保了在优化过程中,高优先级任务的性能始终得到优先保障。

NMT的项目地址

arXiv技术论文:https://arxiv.org/pdf/2412.12092

NMT主要应用

推荐系统:在电商平台优化商品推荐,优先提高购买转化率,同时考虑点击率和用户满意度,提升购物体验和销售额。

搜索引擎:在搜索引擎优化搜索结果排序,优先保证结果相关性,兼顾权威性和用户满意度,提高搜索质量和体验。

自然语言处理:在机器翻译优先确保翻译准确性,优化流畅性和一致性,提升翻译质量,满足跨语言沟通需求。

金融风控:在信贷审批中优先控制信贷风险,确保贷款安全,提高审批效率和客户满意度,优化审批流程。