NanoFlow项目简介

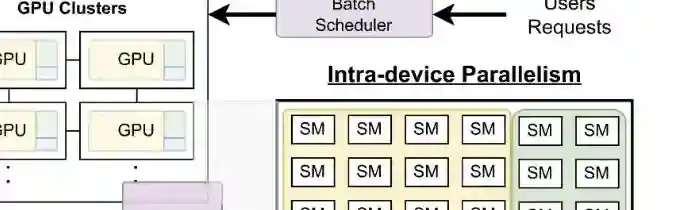

NanoFlow 是一个高性能的服务框架,专为大型语言模型(LLMs)设计,以提高模型的推理吞吐量。它通过在单个设备内部并行使用计算、内存和网络资源,优化了模型的推理过程。并行处理机制使得 NanoFlow 能同时处理更多的请求,并且保证快速响应,从而显著提升了系统的整体性能和用户体验。

NanoFlow优势介绍

提高推理吞吐量:NanoFlow 的核心目标是最大化模型的推理吞吐量,即在保证合理延迟的前提下,提高每秒处理的令牌(token)数量。

设备内并行性:通过操作级别的流水线和执行单元调度,NanoFlow 能在单个设备内并行处理不同的操作,从而提高资源的利用率。

自动化参数搜索:NanoFlow 使用自动化的参数搜索算法来适应不同的模型,减少了人工干预,简化了模型的部署和优化过程。

全局批处理调度:通过全局批处理调度器管理请求,选择最佳的批处理大小,以提高计算效率。

操作级别的并行性引擎:将请求分割为更小的批次(nano-batches),并分配给不同的执行单元,实现操作级别的并行性。

NanoFlow详细报告

全局批处理调度器:通过管理请求并选择最佳的密集批处理大小,以提高计算效率。

设备内并行性引擎:将请求分割为更小的批次(称为 nano-batches),并分配给不同的执行单元,实现操作级别的并行性。

KV缓存管理器:通过预测峰值内存使用情况,并及时将已完成请求的 KV 缓存卸载到较低层次的存储器中,优化内存使用。

NanoFlow的项目地址

GitHub 仓库地址:https://github.com/efeslab/Nanoflow

arXiv技术论文:https://arxiv.org/pdf/2408.12757

如何使用NanoFlow

访问 GitHub 仓库:前往 GitHub 仓库以获取 NanoFlow 的最新版本和相关文档。

阅读文档:在 GitHub 仓库中,查看 README 文件和相关的文档。

安装框架:使用特定的命令或者通过包管理器安装。

运行示例:运行示例代码确保 NanoFlow 可以正常工作。

自定义和扩展:根据需求自定义和扩展 NanoFlow。

NanoFlow主要应用

在线客服系统:在需要快速响应大量客户咨询的环境中,NanoFlow 能提供高效的自动回复服务,提升客户体验。

内容生成平台:对于需要生成个性化或大量动态内容的媒体和社交平台,NanoFlow 能快速生成文本内容,满足用户需求。

自动化办公:在企业内部,NanoFlow 可以帮助自动化处理文档、报告和数据分析等任务,提高工作效率。

多GPU环境:在拥有多个 GPU 的数据中心或云计算环境中,NanoFlow 能优化资源分配,提高整体的计算效率和性能。