-

QVQ – 阿里通义开源的视觉推理模型

QVQ项目简介 QVQ是阿里基于Qwen2-VL-72B构建的开源多模态推理模型,结合视觉理解和复杂问题解决能力,提升人工智能的认知能力。QVQ在视觉推理任务中展现出增强的能力,尤其在需要复杂分析思维的领域表现出色。QVQ在MMMU评测中取得了70.3的高分,在各项数学相关基准测试中相比Qwen2-VL-72B-Instruct 有显著提升。QVQ致力实现全能和智能的模型,能深度思考和推理,应对复…- 3

-

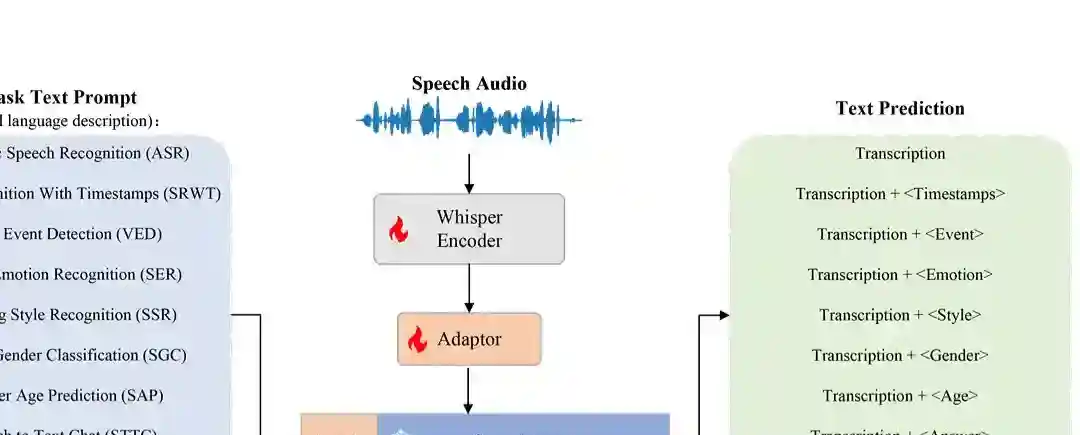

OSUM – 西北工业大学开源的语音理解模型

OSUM项目简介 OSUM(Open Speech Understanding Model)是西北工业大学计算机学院音频、语音与语言处理研究组推出的开源语音理解模型。OSUM结合Whisper编码器和Qwen2 LLM,支持语音识别(ASR)、语音情感识别(SER)、说话者性别分类(SGC)等多种语音任务。OSUM基于“ASR+X”多任务训练策略,用模态对齐和目标任务的优化,实现高效稳定的训练。O…- 2

-

CogSound – 智谱AI最新推出的音效模型

CogSound项目简介 CogSound是智谱AI最新推出的音效模型,能为无声视频增添动人的音效。 基于GLM-4V的视频理解能力,CogSound能精准识别理解视频背后的语义和情感,为无声视频添加与之相匹配的音频内容,可以生成更复杂的音效,如爆炸、水流、乐器、动物叫声、交通工具声等。模型的推出标志着智谱AI在视频生成领域的技术进步,特别是在提升视频的多模态体验方面,增强视频的沉浸感和真实感。 …- 5

-

交交 – 上海交大推出的口语对话情感大模型

交交项目简介 交交是上海交通大学听觉认知与计算声学实验室推出的全球首个纯学术界自研的口语对话情感大模型。交交具备多人对话、多语言交流、方言理解、角色扮演、情感互动及知识问答等强大功能,支持汉语、英语、日语、法语等多种语言,能精准识别中文方言。交交基于创新技术,实现端到端语音对话、多语言理解、多人互动及实时音色克隆。交交展现强大的语音交互能力,为智能语音助手领域带来新的突破。 交交优势介绍 多人对话…- 1

-

DeepSeek-V2.5 – DeepSeek开源的融合通用和代码能力的AI模型

DeepSeek-V2.5项目简介 DeepSeek-V2.5 是DeepSeek推出的融合通用与代码能力的全新开源模型。保留了之前 Chat 模型的通用对话能力以及 Coder 模型的代码处理能力,更好地对齐了人类的偏好,并且在写作任务、指令跟随等多个方面实现了显著的提升。DeepSeek-V2.5 现在可以通过网页端和 API 全面使用,已开源至HuggingFace,便于开发者使用和二次开发…- 2

-

FLUX1.1 – Black Forest Labs团队推出的超写实AI图像生成模型,代号“蓝莓”

FLUX1.1项目简介 FLUX1.1 Pro是Black Forest Labs团队最新推出的升级版AI图像生成模型,代号“蓝莓”,提供比前代快6倍的生成速度,同时保持了图像的及时性和多样性。FLUX1.1目前仅包含FLUX1.1 Pro模型,预计后续会开放更多的系列模型,FLUX1.1 Pro通过API对外开放,主要面向开发者和企业用户。FLUX1.1 Pro的一个独特功能是支持通过模仿单反相…- 0

-

ID-Animator – 腾讯等推出的个性化人物视频生成框架

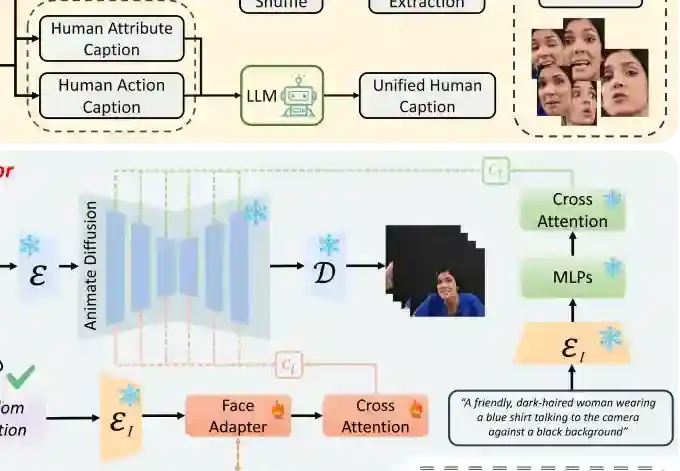

ID-Animator项目简介 ID-Animator是由来自腾讯光子工作室、中科大和中科院合肥物质科学研究院的研究人员推出的一种零样本(zero-shot)人类视频生成技术,能够根据单张参考面部图像生成个性化视频,同时保留图像中的人物身份特征,并能够根据文本提示调整视频内容。该框架通过结合预训练的文本到视频扩散模型和轻量级面部适配器,实现了高效的视频生成,且无需针对特定身份进行额外的训练。ID-…- 2

-

Ichigo – 开源的多模态AI语音助手,实时处理语音和文本的交织序列

Ichigo项目简介 Ichigo是开源的多模态AI语音助手,采用混合模态模型,能实时处理语音和文本的交织序列。基于将语音直接量化为离散令牌,用统一的变换器架构同时处理语音和文本,实现跨模态的联合推理和生成。基于此方法提高了处理速度,降低算力消耗,让首令牌生成的延迟仅为111毫秒,远低于现有模型,让Ichigo能提供接近实时的语音交互体验。 Ichigod主要功能 实时语音处理:Ichigo实时处…- 0